01 dez 2025

[Nota do Website: Nessa viagem feita pelo jornalista do Guardian, pode-se constatar que realidade vive o chamado Vale do Silício. E é interessante porque contrasta os jovens desenvolvedores das Big Techs com os velhos investidores. Esses, de maneira descompromissada, somente ‘investem’ para os jovens ‘delirarem’. Mas no final ficam questionamentos dos agora antigos primeiros cientistas da IA, sobre que futuro será esse face à profunda mudança de rumos dos primórdios da ciência para os atuais ‘negócios’ competitivos e até destrutivos dos oligarcas dominantes da IA].

No Vale do Silício, empresas rivais estão investindo trilhões de dólares para alcançar um objetivo que pode mudar a humanidade – ou potencialmente destruí-la.

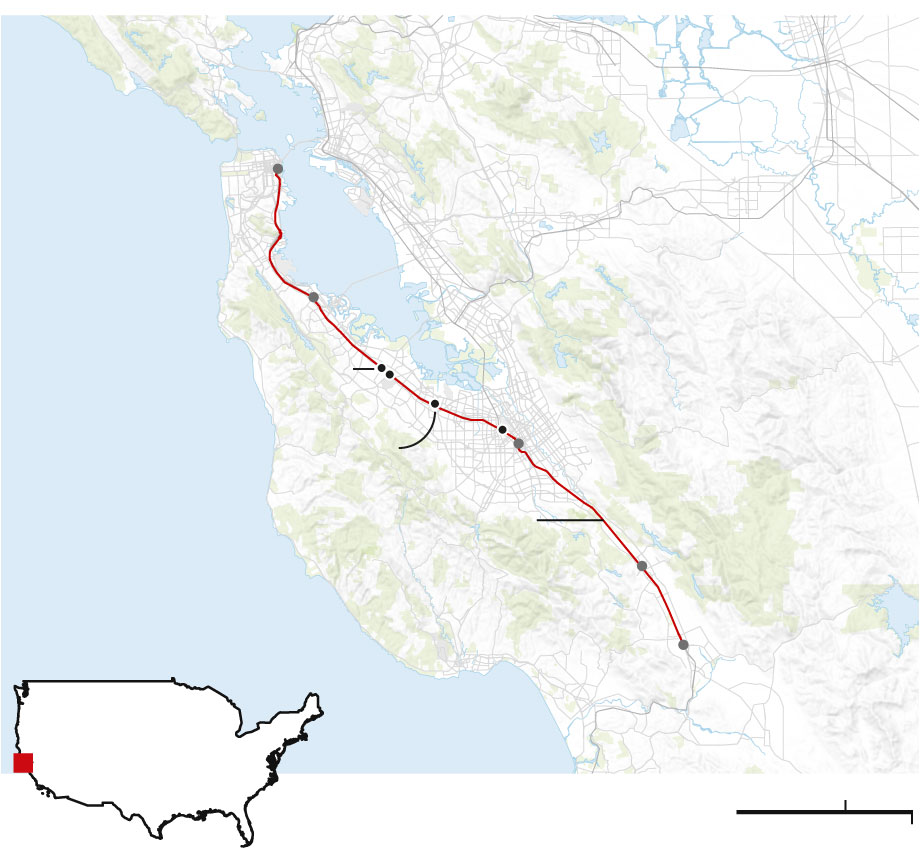

No trem das 8h49 que atravessa o Vale do Silício, as mesas estão lotadas de jovens absortos em seus laptops, fones de ouvido, digitando códigos sem parar.

Enquanto as colinas do norte da Califórnia desfilam diante dos olhos, instruções dos chefes surgem nas telas: corrija este bug; adicione um novo script. Não há tempo para apreciar a vista. Esses trabalhadores são soldados rasos na corrida global rumo à inteligência artificial geral – quando os sistemas de IA se tornarem tão ou mais capazes que humanos altamente qualificados.

Aqui na região da Baía de São Francisco, algumas das maiores empresas do mundo estão competindo para obter algum tipo de vantagem. E, por sua vez, estão competindo com a China.

O lugar de partida: San Francisco; depois mais ao sul: San Mateo; a seguir: Menlo Park e Palo Alto; depois Mountain View, Santa Clara, San Jose Diridon, Caltrain, Morgan Hill e por fim, Gilroy.

Essa corrida para assumir o controle de uma tecnologia que pode remodelar o mundo está sendo alimentada por apostas de trilhões de dólares feitas pelos capitalistas mais poderosos dos EUA.

Os cientistas da computação desembarcam em Mountain View para trabalhar no Google DeepMind, em Palo Alto para o centro de talentos da Universidade de Stanford e em Menlo Park para a Meta, onde Mark Zuckerberg tem oferecido pacotes de remuneração de US$ 200 milhões por pessoa para atrair especialistas em IA e desenvolver a “superinteligência”.

Passageiros desembarcam de um trem na estação de Palo Alto. Fotografia: Christie Hemm Klok/The Guardian

Para a fabricante de chips de IA Nvidia, cujo chefe sorridente, Jensen Huang, possui uma fortuna de US$ 160 bilhões, os funcionários desembarcam em Santa Clara. Já o fluxo migratório é para São Francisco, onde trabalham na OpenAI e na Anthropic, startups de IA que juntas valem meio trilhão de dólares – desde que a tão prevista bolha da IA não estoure.

Os avanços surgem em ritmo acelerado, com cada semana trazendo o lançamento de um novo e significativo desenvolvimento em IA.

Cada vez que chegamos ao topo da montanha da besteira, descobrimos que o pior ainda está por vir. Alex Hanna, coautor de The AI Con

O cofundador da Anthropic, Dario Amodei, prevê que a Inteligência Artificial Geral (IAG) poderá ser alcançada em 2026 ou 2027. O diretor executivo da OpenAI, Sam Altman, acredita que o progresso é tão rápido que em breve ele poderá criar uma IA para substituí-lo como chefe.

“Todo mundo está trabalhando o tempo todo”, disse Madhavi Sewak, líder sênior do Google DeepMind, em uma palestra recente. “É extremamente intenso. Não parece haver nenhum ponto de parada natural, e todos estão sendo realmente esmagados. Mesmo as pessoas que são muito ricas agora… tudo o que fazem é trabalhar. Não vejo nenhuma mudança no estilo de vida de ninguém. Ninguém tira férias. As pessoas não têm tempo para os amigos, para os hobbies, para… as pessoas que amam.”

Essas são as empresas que estão numa corrida para moldar, controlar e lucrar com a IAG (Inteligência Artificial Generativa) – o que Amodei descreve como “um país de gênios num centro de dados”. Elas estão investindo em uma tecnologia que, em teoria, poderia eliminar milhões de empregos de escritório e representar sérios riscos em armas biológicas e segurança cibernética.

- US$ 2,8 trilhões – Previsão de gastos com centros de dados de IA até o final da década

Ou talvez inaugure uma nova era de abundância, saúde e prosperidade. Ninguém tem certeza, mas logo descobriremos. Por enquanto, a incerteza energiza e aterroriza a região da Baía de São Francisco.

Tudo isso está sendo sustentado por enormes novas apostas dos capitalistas de risco do Vale do Silício, que mais que dobraram no último ano, levando a discussões sobre uma bolha perigosa. Em setembro, a corretora Citigroup, de Wall Street, revisou para cima sua previsão de gastos com data centers de IA até o final da década para US$ 2,8 trilhões – mais do que toda a produção econômica anual do Canadá, Itália ou Brasil.

No entanto, em meio a todo o dinheiro e otimismo, há outras vozes que não engolem a propaganda. Como disse Alex Hanna, coautor do livro dissidente ” The AI Con”: “Toda vez que chegamos ao topo da montanha de mentiras, descobrimos que há coisas piores por vir.”

Fileiras de servidores no centro de dados do Facebook em Fort Worth, Texas. Fotografia: Fort Worth Star-Telegram/TNS

Chegando em Santa Clara

A força bruta dos ‘gritadores’

“É aqui que a IA ganha vida!”, exclamou Chris Sharp.

Em Santa Clara, no extremo sul da linha de trem suburbano Caltrain, fileiras de microprocessadores multimilionários em gaiolas de aço preto rugiam como motores a jato dentro de um galpão industrial sem janelas.

O barulho ensurdecedor de 120 decibéis tornava quase impossível ouvir o diretor de tecnologia da Digital Realty exibindo seus “gritadores”.

Ouvir esse som é sentir na pele a força bruta envolvida no desenvolvimento da tecnologia de IA. Cinco minutos de exposição deixaram os ouvidos zumbindo por horas. É o ruído de refrigeradores de ar resfriando supercomputadores sensíveis alugados para empresas de IA treinarem seus modelos e responderem a bilhões de solicitações diárias — desde como assar um brownie até como atingir drones militares letais.

Nas proximidades, encontravam-se mais centros de dados de IA, operados pela Amazon, Google, a empresa chinesa Alibaba, Meta e Microsoft. Santa Clara também abriga a Nvidia, a principal empresa da revolução da IA, que, por meio da venda de sua tecnologia líder de mercado, viu seu valor aumentar 30 vezes desde 2020, chegando a valer US$ 4,3 trilhões. Centros de dados ainda maiores estão sendo construídos não apenas nos EUA, mas também na China, Índia e Europa. A próxima fronteira é o lançamento de centros de dados no espaço.

O centro de dados de IA Stargate em construção em Abilene, Texas. Fotografia: Bloomberg/Getty Images

A Meta está construindo uma instalação na Louisiana grande o suficiente para cobrir boa parte de Manhattan. Há relatos de que o Google planeja um centro de US$ 6 bilhões na Índia e está investindo £ 1 bilhão em um data center de IA ao norte de Londres. Mesmo uma fábrica de IA do Google relativamente modesta, planejada para Essex, deverá emitir uma pegada de carbono equivalente a 500 voos de curta distância por semana.

Alimentado por uma central elétrica local a gás, o conjunto de circuitos em uma sala do centro de dados da Digital Realty em Santa Clara consumia a mesma energia que 60 casas. Um longo corredor branco, que dava para várias salas repletas de outros dispositivos de alto consumo, estendia-se até onde a vista alcançava.

Às vezes, os engenheiros de plantão percebem que o rugido diminui para um rosnado mais constante quando a demanda das empresas de tecnologia cai. Não demora muito para que o grito retorne.

Estação ferroviária de Mountain View. Fotografia: Christie Hemm Klok/The Guardian

Chegando em Mountain View

“Se for só acelerar e não frear, o resultado é terrível.”

Pegue o trem três estações ao norte de Santa Clara até Mountain View e o rugido diminui. Os cientistas da computação que realmente dependem desses equipamentos trabalham em um ambiente mais tranquilo.

Em um extenso campus cercado por pinheiros sussurrantes, a sede americana do Google DeepMind se assemelha mais a uma tenda de circo do que a um laboratório. Os funcionários chegam em táxis autônomos da Waymo, movidos pela inteligência artificial do Google. Outros chegam pedalando em bicicletas amarelas, vermelhas, azuis e verdes com a marca Google.

Sede do Google em Mountain View, Califórnia. Fotografia: Bloomberg/Getty Images

O Google DeepMind está no grupo líder de empresas de IA dos EUA, disputando o primeiro lugar em uma corrida que atinge novos níveis de intensidade competitiva.

Este foi o ano dos salários de estrelas do esporte para especialistas em IA na faixa dos vinte anos e do surgimento de novos concorrentes estrondosos, como o xAI de Elon Musk, o projeto de superinteligência de Zuckerberg e o DeepSeek na China.

Também houve uma crescente abertura em relação à promessa ambígua da Inteligência Artificial Geral (IAG), o que pode dar a impressão de que as empresas de IA estão acelerando e freando simultaneamente. Por exemplo, 30 das mentes mais brilhantes do Google DeepMind escreveram nesta primavera que a IAG representa riscos de “incidentes com consequências suficientemente graves para prejudicar significativamente a humanidade”.

Em setembro, a empresa também explicava como lidaria com “modelos de IA com poderosas capacidades de manipulação que poderiam ser mal utilizados para alterar crenças e comportamentos de forma sistemática e substancial… resultando, razoavelmente, em danos adicionais esperados em grande escala”.

Esses alertas graves parecem dissonantes no interior da sede, com seus sofás alegres em tons de tangerina, pufes Fatboy e áreas de trabalho com códigos de cores e nomes como Coral Cove e Archipelago.

Tom Lue, do Google DeepMind. Fotografia: Ben Peter Catchpole/PR Image

“O aspecto mais interessante, e ao mesmo tempo mais desafiador, do meu trabalho é [descobrir] como encontrar esse equilíbrio entre sermos realmente ousados, agirmos com rapidez, em um ritmo tremendo e com inovação, e ao mesmo tempo fazermos isso de forma responsável, segura e ética”, disse Tom Lue, vice-presidente do Google DeepMind responsável por políticas, assuntos jurídicos, segurança e governança, que interrompeu seu trabalho por 30 minutos para conversar com o The Guardian.

A Casa Branca de Donald Trump adota uma abordagem permissiva em relação à regulamentação da IA, e não existe uma legislação abrangente em âmbito nacional nos EUA ou no Reino Unido. Yoshua Bengio, cientista da computação conhecido como um dos padrinhos da IA, afirmou em uma palestra do TED neste verão: “Um sanduíche tem mais regulamentação do que a IA.”

Os concorrentes, portanto, perceberam que têm a responsabilidade de definir os limites do que as IAs devem ser autorizadas a fazer.

“Nosso cálculo não se baseia tanto em ficar de olho no que as outras empresas estão fazendo, mas sim em como garantir que sejamos nós a liderar, para que tenhamos influência no desenvolvimento dessa tecnologia e na definição das normas em toda a sociedade”, disse Lue. “É preciso estar em uma posição de força e liderança para fazer isso.”

A questão de qual inteligência artificial (IA) dominará o mercado está sempre presente. Será a de pessoas como Lue, ex-advogado do governo Obama, e seu chefe, o cofundador da DeepMind e ganhador do Prêmio Nobel, Demis Hassabis? Será a de Musk ou a de Zuckerberg? A de Altman ou a de Amodei na Anthropic? Ou, como teme a Casa Branca, será a da China?

“Se for apenas uma corrida sem limites, sem freios, e basicamente uma corrida para o fundo do poço, isso terá um resultado terrível para a sociedade”, disse Lue, que está pressionando por uma ação coordenada entre os pilotos e os governos.

Mas a regulamentação estatal rigorosa também pode não ser a solução. “Apoiamos regulamentações que ajudem a IA a ser implementada no mundo de forma positiva”, disse Helen King, vice-presidente de responsabilidade do Google DeepMind. “A questão delicada é sempre como regulamentar de uma forma que não prejudique os bons e não dê brechas aos maus.”

‘Tramas’ e sabotagem

As empresas de vanguarda em IA sabem que estão brincando com fogo ao desenvolver sistemas mais poderosos que se aproximam da Inteligência Artificial Generativa (AGI).

Recentemente, a OpenAI foi processada pela família de um jovem de 16 anos que se suicidou incentivado pelo ChatGPT. Em novembro, outras sete ações judiciais foram movidas, alegando que a empresa lançou às pressas uma atualização do ChatGPT sem os devidos testes, que, em alguns casos, atuou como um “instrutor de suicídio”.

Adam Raine. Fotografia: Cortesia da família Raine.

A OpenAI classificou a situação como “de partir o coração” e afirmou que está tomando providências.

A empresa também descreveu como detectou a forma como os modelos podem fornecer informações enganosas. Isso pode significar algo tão simples quanto fingir ter concluído uma tarefa inacabada. Mas o receio da OpenAI é que, no futuro, as IAs possam “de repente ‘virar a chave’ e começar a se envolver em esquemas significativamente prejudiciais”.

Em novembro, a Anthropic revelou que sua IA Claude Code, amplamente considerada o melhor sistema para automatizar a programação de computadores, foi usada por um grupo patrocinado pelo Estado chinês no “primeiro caso documentado de um ataque cibernético executado em grande escala, praticamente sem intervenção humana”.

Acordem, porra! Isso vai nos destruir – mais cedo do que imaginamos. Senador dos EUA sobre X

A notícia causou arrepios em alguns. “Acordem para a realidade”, disse um senador americano no site X. “Isso vai nos destruir — mais cedo do que imaginamos”. Em contrapartida, o professor Yann LeCun, que está prestes a se aposentar após 12 anos como cientista-chefe de IA da Meta, afirmou que a Anthropic estava “assustando todo mundo” para incentivar regulamentações que poderiam prejudicar os concorrentes.

Testes com outros modelos de última geração revelaram que, por vezes, eles sabotavam a programação destinada a garantir que os humanos pudessem interrompê-los, uma característica preocupante chamada “resistência ao desligamento”.

Mas, com quase US$ 2 bilhões por semana em novos investimentos de capital de risco direcionados à IA generativa no primeiro semestre de 2025, a pressão para gerar lucros aumentará rapidamente. As empresas de tecnologia perceberam que poderiam lucrar muito monetizando a atenção humana em plataformas de mídia social, o que causou sérios problemas sociais. O receio é que a maximização do lucro na era da IA possa resultar em consequências adversas muito maiores.

Estação Caltrain de Palo Alto. Fotografia: Christie Hemm Klok/The Guardian

Chegando em Palo Alto

‘Agora é muito difícil optar por não participar’

Três paradas ao norte, o Caltrain chega à estação de Palo Alto. É uma curta caminhada até o grandioso campus da Universidade de Stanford, onde doações de bilionários do Vale do Silício impulsionam um rápido fluxo de jovens talentos em IA para as divisões de pesquisa do Google DeepMind, Anthropic, OpenAI e Meta.

Os graduados de elite de Stanford ascendem rapidamente nas empresas de tecnologia da Área da Baía, o que significa que pessoas na faixa dos 20 ou 30 anos frequentemente ocupam posições de poder na corrida pela Inteligência Artificial Generativa (IAG). Entre os ex-alunos de Stanford estão Altman, o presidente da OpenAI, Bret Taylor, e o CEO do Google, Sundar Pichai. Mais recentemente, entre os ex-alunos de Stanford está Isa Fulford, que com apenas 26 anos já é uma das líderes de pesquisa da OpenAI. Ela trabalha na capacidade do ChatGPT de realizar ações em nome dos humanos – a chamada IA “agente”.

Isa Fulford, pesquisadora da OpenAI. Fotografia: Winni Wintermeyer/The Guardian

“Um dos momentos estranhos é ler nas notícias sobre coisas que você está vivenciando”, disse ela ao The Guardian.

Após crescer em Londres, Fulford estudou ciência da computação em Stanford e logo ingressou na OpenAI, onde agora está no centro de um dos aspectos mais importantes da corrida pela Inteligência Artificial Generativa (AGI) – a criação de modelos que podem se autodirecionar para objetivos, aprender e se adaptar.

Ela está envolvida na definição dos limites de decisão para esses agentes de IA cada vez mais autônomos, para que saibam como responder caso sejam solicitados a realizar tarefas que possam desencadear riscos cibernéticos ou biológicos e para evitar consequências indesejadas. É uma grande responsabilidade, mas ela não se intimida.

“Parece que estamos vivendo um momento realmente especial”, disse ela. “Me sinto muito sortuda por estar trabalhando nisso.”

Essa juventude não é incomum. Um pouco mais ao norte, no campus da Meta em Menlo Park, o chefe da iniciativa de Zuckerberg em busca da “superinteligência” é Alexandr Wang, de 28 anos, que abandonou o Instituto de Tecnologia de Massachusetts (MIT). Um de seus principais pesquisadores de segurança tem 31 anos. O vice-presidente do ChatGPT da OpenAI, Nick Turley, tem 30 anos.

O Vale do Silício sempre foi movido pela juventude, e se experiência é necessária, ela pode ser encontrada nos altos escalões das empresas de IA. Mas a maioria dos líderes seniores da OpenAI, Anthropic, Google DeepMind, X e Meta são muito mais jovens do que os CEOs das maiores empresas públicas dos EUA, cuja idade média é de 57 anos.

“O fato de terem pouca experiência de vida provavelmente contribui para o seu pensamento limitado e, na minha opinião, destrutivo”, disse Catherine Bracy, ex-operadora da campanha de Obama e atual diretora da organização de campanha TechEquity.

Um pesquisador sênior, contratado recentemente por uma grande empresa de IA, acrescentou: “Os [funcionários mais jovens] estão fazendo o possível para fazer o que acham certo, mas se tiverem que confrontar os executivos, é porque têm menos experiência nas dinâmicas da política corporativa.”

Outro fator é que os pesquisadores de IA mais brilhantes, que antes passavam anos em laboratórios universitários, são contratados mais rapidamente do que nunca por empresas privadas que buscam a Inteligência Artificial Generativa (IAG). Essa fuga de cérebros concentra o poder nas mãos de proprietários motivados pelo lucro e seus investidores de capital de risco.

É preciso garantir que os benefícios sejam distribuídos por toda a sociedade, em vez de beneficiarem apenas Elon Musk.” John Etchemendy, codiretor do Instituto Stanford para Inteligência Artificial Centrada no Ser Humano.

John Etchemendy, um ex-reitor de Stanford de 73 anos que agora é codiretor do Instituto de Inteligência Artificial Centrada no Ser Humano de Stanford, alertou para uma crescente lacuna de capacidade entre os setores público e privado.

“É desequilibrado porque é uma tecnologia muito cara”, disse ele. “No início, as empresas que trabalhavam com IA eram muito abertas sobre as técnicas que usavam. Elas publicavam, e era quase acadêmico. Mas depois começaram a restringir e dizer: ‘Não, não queremos falar sobre… a tecnologia por trás dos bastidores, porque é muito importante para nós – é proprietária’.”

Etchemendy, um eminente filósofo e lógico, começou a trabalhar com IA na década de 1980 para traduzir manuais de instruções de produtos eletrônicos de consumo japoneses.

Do seu escritório no edifício de ciência da computação Gates, no campus de Stanford, ele agora apela aos governos para que criem um contrapeso às gigantescas empresas de IA, investindo em uma instalação para pesquisa acadêmica independente. Ela teria uma função semelhante à do CERN, organização estatal para física de altas energias localizada na fronteira entre a França e a Suíça. A presidente da Comissão Europeia, Ursula von der Leyen, defendeu algo similar, e seus defensores acreditam que isso poderia direcionar a tecnologia para resultados confiáveis e de interesse público.

“Essas são tecnologias que vão gerar o maior aumento de produtividade já visto”, disse Etchemendy. “É preciso garantir que os benefícios sejam distribuídos por toda a sociedade, em vez de beneficiarem apenas Elon Musk.”

Mas um organismo assim parece estar a léguas de distância do fervor da corrida pelo ouro rumo à Inteligência Artificial Generativa (IAG).

- 24 – A idade mediana dos empreendedores que atualmente recebem financiamento da incubadora de startups Y Combinator.

Certa noite, enquanto degustavam salada de burrata e vinho Pinot Noir em um restaurante italiano sofisticado, um grupo de jovens fundadores de startups de IA, na faixa dos vinte anos, foi incentivado por seu anfitrião, um investidor de capital de risco, a compartilhar suas opiniões contundentes sobre o estado atual da corrida espacial.

Eles faziam parte de uma comunidade de empreendedores em rápido crescimento, empenhados em aplicar IA a ideias lucrativas do mundo real, e não havia nenhum apoio para frear o progresso rumo à IAG (Inteligência Artificial Generativa) a fim de controlar seus impactos sociais. “Não fazemos isso no Vale do Silício”, disse um deles. “Se todos aqui pararem, isso continua”, disse outro. “É muito difícil ficar de fora agora.”

Por vezes, as suas declarações eram surpreendentes. Um dos fundadores afirmou, sem rodeios, que pretendiam vender a sua empresa em fase inicial, que criaria personagens de IA para existirem de forma autónoma nas redes sociais, por mais de mil milhões de dólares.

Outro declarou: “A moralidade é melhor compreendida como um problema de aprendizado de máquina.” O vizinho disse que a IA significaria que todos os tipos de câncer seriam curados em 10 anos.

Essa comunidade de empreendedores está ficando mais jovem. A idade média dos financiados pela incubadora de startups Y Combinator, de São Francisco, caiu de 30 anos em 2022 para 24 anos, segundo informações recentes.

Talvez os investidores de capital de risco, que quase sempre são anos, senão décadas, mais velhos, devessem assumir a responsabilidade por como a tecnologia afetará o mundo? Não, novamente. Dizer que os investidores de capital de risco têm mais responsabilidade do que perseguir seus objetivos de investimento é uma “visão paternalista”, afirmaram.

Agressivos, inteligentes e cheios de entusiasmo – os jovens talentos que impulsionam o boom da IA querem tudo e rápido.

Os edifícios de número 1455 e 1515 da Third Street, que abrigam a sede da Uber Technologies Inc. e os escritórios da OpenAI, respectivamente, estão localizados no bairro de Mission Bay, em São Francisco. Fotografia: Bloomberg/Getty Images

Chegando em San Francisco

‘Como os cientistas que assistiam ao Projeto Manhattan’

Ao desembarcar do Caltrain na estação terminal da 4th Street em São Francisco, atravessar o Mission Creek, você chegará à sede da OpenAI, que está a caminho de se tornar a primeira empresa de IA a valer um trilhão de dólares.

Música eletrônica dançante e vibrante ecoa pela área de recepção, enquanto alguns dos 2.000 funcionários chegam para trabalhar. Há poltronas confortáveis, almofadas espalhadas e costeletas – um arquiteto foi incumbido de capturar a atmosfera de uma aconchegante casa de campo, em vez de um “castelo corporativo de ficção científica”, disse Altman.

A biblioteca dentro do escritório da OpenAI em São Francisco. Fotografia: Christie Hemm Klok/New York Times/Redux/eyevine

Mas isso não faz jus à urgência da corrida pela Inteligência Artificial Generativa (IAG). Nos andares superiores, engenheiros trabalham arduamente em cubículos à prova de som. O café está lotado de pedidos e há cápsulas de descanso para os verdadeiramente exaustos.

Aqui, a equipe está em uma corrida diária com os concorrentes para lançar produtos de IA que possam gerar lucro hoje. É “muito, muito competitivo”, disse um executivo sênior. Em uma semana recente, a OpenAI lançou compras com “checkout instantâneo” por meio do ChatGPT, a Anthropic lançou uma IA capaz de escrever código autonomamente por 30 horas para construir softwares completamente novos, e a Meta lançou uma ferramenta, o Vibes, que permite aos usuários preencher seus feeds de redes sociais com vídeos gerados por IA, ao que a OpenAI respondeu com sua própria versão, o Sora.

Amodei, CEO da Anthropic, empresa rival de IA fundada por pessoas que deixaram a OpenAI alegando preocupações com a segurança, previu que a IA poderia eliminar metade de todos os empregos de nível básico em escritórios. Quanto mais a tecnologia se aproxima da Inteligência Artificial Generativa (IAG), maior seu potencial para remodelar o mundo e mais incertos os resultados. Tudo isso parece pesar sobre os líderes. Em uma entrevista neste verão, Altman disse que muitas pessoas que trabalham com IA se sentiam como os cientistas que assistiam aos testes da bomba atômica do Projeto Manhattan em 1945.

Um protesto “Pare a IA” em julho em frente aos escritórios da OpenAI em São Francisco. Fotografia: Robert Booth/The Guardian

“Na maioria dos trabalhos de desenvolvimento de produtos padrão, você sabe exatamente o que acabou de construir”, disse Turley, da ChatGPT. “Você sabe como ele vai se comportar. Neste trabalho, é a primeira vez que trabalho com uma tecnologia em que você precisa sair e conversar com as pessoas para entender o que ela realmente pode fazer. É útil na prática? Deixa a desejar? É divertido? É prejudicial na prática?”

Turley, que ainda era estudante de graduação quando Altman e Musk fundaram a OpenAI em 2015, tenta tirar os fins de semana de folga para se desconectar e refletir, pois “trabalhar nisso é algo bastante profundo”. Quando entrou para a OpenAI, a Inteligência Artificial Generativa (IAG) era “um conceito muito abstrato, quase mítico – como um grito de guerra para mim”, disse ele. Agora, está se tornando realidade.

Nick Turley, chefe do ChatGPT. Fotografia: Winni Wintermeyer/The Guardian

“Existe um senso compartilhado de responsabilidade, pois os riscos são muito altos e a tecnologia que estamos desenvolvendo não é apenas um software comum”, acrescentou seu colega Giancarlo Lionetti, diretor comercial da OpenAI.

O maior choque de realidade para a OpenAI até o momento ocorreu em agosto, quando foi processada pela família de Adam Raine, de 16 anos, um californiano que se suicidou após ser incentivado, durante meses, por conversas com o ChatGPT. A OpenAI tem se esforçado para alterar sua tecnologia a fim de evitar a repetição desse caso trágico de desalinhamento da IA. O chatbot deu ao adolescente conselhos práticos sobre seu método de suicídio e se ofereceu para ajudá-lo a escrever uma carta de despedida.

Frequentemente ouvimos pesquisadores de IA dizerem que desejam que o avanço da IAG (Inteligência Artificial Generativa) “corra bem”. É uma expressão vaga que sugere o desejo de que a tecnologia não cause danos, mas sua imprecisão mascara a apreensão.

Altman falou sobre “tecnologia de ficção científica maluca se tornando realidade” e sobre ter “preocupações extremamente profundas sobre o que a tecnologia está fazendo com as crianças”. Ele admitiu: “Ninguém sabe o que vai acontecer. É como se tivéssemos que descobrir. É algo estranho e emergente.”

“Claramente existem riscos reais”, disse ele em uma entrevista com o comediante Theo Von, que não teve muitas risadas. “Dá a impressão de que deveríamos poder dizer algo mais do que isso, mas, na verdade, acho que tudo o que sabemos agora é que descobrimos… algo extraordinário que vai remodelar o curso da nossa história.”

Ainda assim, apesar da incerteza, a OpenAI está investindo somas exorbitantes em data centers cada vez mais poderosos na corrida final rumo à Inteligência Artificial Generativa (AGI). Seu data center em construção em Abilene, Texas, é uma peça central de seu programa “Stargate” de US$ 500 bilhões e é tão vasto que parece uma tentativa de transformar a superfície da Terra em uma placa de circuito impresso.

Periodicamente, pesquisadores deixam a OpenAI e se manifestam. Steven Adler, que trabalhava em avaliações de segurança relacionadas a armas biológicas, saiu em novembro de 2024 e criticou a abrangência dos testes realizados pela empresa. Eu o encontrei perto de sua casa em São Francisco.

Existem pessoas que trabalham em empresas de IA de ponta que acreditam sinceramente que há uma chance de suas empresas contribuírem para o fim do mundo.” Steven Adler, ex-pesquisador da OpenAI

“Sinto-me muito apreensivo com o fato de cada empresa ter os seus próprios processos de segurança personalizados e diferentes personalidades a fazerem o seu melhor para se virarem, em vez de existir um padrão comum em toda a indústria”, disse ele. “Há pessoas que trabalham nas empresas de IA de vanguarda que acreditam sinceramente que existe a possibilidade de a sua empresa contribuir para o fim do mundo, ou para alguma catástrofe um pouco menor, mas ainda assim terrível. Muitas vezes, sentem-se individualmente impotentes para fazer algo a respeito e, por isso, fazem o que consideram ser melhor para tentar minimizar os danos.”

Até agora, poucos obstáculos foram encontrados para os competidores. Em setembro, centenas de figuras proeminentes pediram por “linhas vermelhas” acordadas internacionalmente para evitar “riscos universalmente inaceitáveis” da IA até o final de 2026. Entre as vozes de alerta estavam dois dos “padrinhos da IA” – Geoffrey Hinton e Bengio – Yuval Noah Harari, autor do best-seller Sapiens, laureados com o Prêmio Nobel e figuras como Daniel Kokotajlo, que deixou a OpenAI no ano passado e ajudou a elaborar um cenário apocalíptico aterrorizante no qual a IA extermina todos os humanos em poucos anos.

Mas Trump não demonstra qualquer intenção de impor entraves burocráticos às empresas de IA e está pressionando o primeiro-ministro britânico, Keir Starmer, para que siga o exemplo.

O medo público cresce no vácuo deixado pela crise. Numa tarde chuvosa de sexta-feira, um pequeno grupo de cerca de 30 manifestantes se reuniu em frente aos escritórios da OpenAI. Havia professores, estudantes, cientistas da computação e sindicalistas, e seus cartazes com os dizeres “Parem a IA” retratavam Altman como um alienígena, alertavam que “A IA rouba seu trabalho para roubar seu emprego” e que “IA = colapso climático”. Um dos manifestantes vestia uma fantasia de robô feita em casa e marchava pelo local.

Um protesto “Pare a IA” em julho em frente aos escritórios da OpenAI em São Francisco. Fotografia: Robert Booth/The Guardian

“Já ouvi falar de superinteligência”, disse Andy Lipson, de 59 anos, professor de Oakland. “Há 20% de chance de que ela nos mate. Há 100% de chance de que os ricos fiquem mais ricos e os pobres fiquem mais pobres.”

Joseph Shipman, de 64 anos, programador de computadores que estudou IA pela primeira vez no MIT em 1978, disse: “Uma entidade que seja sobre-humana em sua inteligência geral, a menos que queira exatamente o que nós queremos, representa um risco terrível para nós.”

“Se não houvesse os incentivos comerciais para lançar o produto no mercado rapidamente e os bilhões de dólares em jogo, talvez em 15 anos pudéssemos desenvolver algo que nos desse confiança de que era controlável e seguro. Mas está acontecendo rápido demais para isso.”

Tradução livre, parcial, de Luiz Jacques Saldanha, dezembro de 2025